苹果花了四年再度推出新款iPhone SE (第二代),被多数人称为iPhone SE2新机,拥有iPhone 8外型/零件/镜头和iPhone 11的A13仿生处理器,值得注意是单镜头可支援人像模式,Halide就针对iPhone SE2人像模式进行深入分析,发现到可透过第三方相机能解除原生人像限制,也可以用来拍摄动物或静态物体,但效果不太好。

如果透过iPhone SE(第二代)内建相机启动人像模式拍摄时,只要拍摄主题并非人物时,相机画面会跳出未检测人物错误,难道iPhone SE 只能限制人像模式才能拍摄吗?

在Halide 其中一位研究开发者Ben Sandofsky 替iPhone SE 镜头与演算法进行实际测试发现,新款iPhone SE2 是一台搭载最新「单图深度预测(Single Image Monocular Depth Estimation)」设备,先前iPhone 都未曾使用过,简单来说就是iPhone SE 使用一颗2D 镜头即可拍出人像模式,不过还需要依赖A13 Bionic 处理器才能够实现。

但是在iPhone XR 不也是一样采用单镜头实现人像模式吗?是这样没有错,iPhone XR 利用镜头传感器的Focus Pixels(相位对焦技术, PDAF) ,可以透过焦点像素视差图提升对焦,进一步实现?粗糙的深度图。

在新款iPhone SE2上则是无法使用Focus Pixels,因为它采用的是比较旧款iPhone 8镜头传感器,只能完全依赖A13仿生晶片和机器学习来产生深度,只有在人像模式中识别到人脸辨识才会启动散景模拟效果,那么为何不能用于宠物或物品上呢?

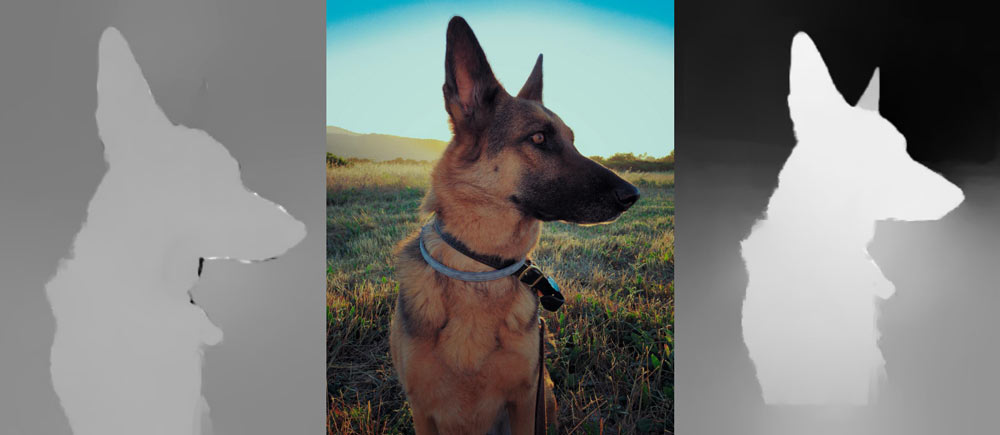

如果想要摆脱人像限制,那就需要依赖第三方相机App 才能够实现,从下方这张图来近一步了解iPhone XR 和iPhone SE2 在深度图差异,可以发现iPhone XR 就算有色彩明显差异可识别动物主体和背景,不过还是难以识别后方狗狗的耳朵和边缘细节,这问题在iPhone SE2 上已经完全改变,深度图非常明显可以识别近远和狗狗边缘的毛细节。

既然iPhone SE2 也能够支援动物识别,为什么没有开放呢?

Sandofsky 在不同场景下拍摄宠物发现,在iPhone SE2 机器学习中无法识别树木,如果刚好在拍摄宠物时,背后有树木之类景色时,手机无法辨别这是一只鹿或是一只狗头上面有树,导致宠物头身上会相同色系时会被视为是主体,并无法判断主体与背景的深浅。

如以iPhone 11 Pro 和iPhone SE2 进行比较,拍摄狗狗躺在地板上图片,会发现到iPhone 11 Pro 在三镜头的优势就非常明显,可以获得更多的数据,在iPhone SE2 由于仅只有单镜头无法正确识别景深,导致只能识别整个走廊的地板。

如果拍摄非生物为主体,会发现到iPhone SE2 同样无法识别前景与背景,导致整块融合再一起,反而在iPhone 11 Pro 能够辨识物体深浅分层。

从以上可得知,Apple 在机器学习过程中已经完美利用分层技术,也能看出再多镜头和演算法下,在辨识深度拥有更佳的效果。

苹果在iOS 12 加入PORTRAIT EFFECTS MATTE (人像效果遮罩, 简称PEM)API,意思是指可透过PEM 来产生一张黑白深度遮罩图,能透过颜色区别了解深浅外,还能看出毛发边缘与细节。

那么就能得知为什么Apple 不打算替iPhone SE2 人像模式功能延伸在宠物或物体拍摄,主要原因是在于人像拍摄效果在拍人部分会获得最佳的效果,也不想让使用者感到失望,这也就是指人类遮罩、机器学习深度图借助于A13 优势下,拍摄人像效果会是最好的。

那么很多人在意iPhone 多镜头对我而言没有作用,只要有单镜头可以拍就够了,的确每个人需求都会不一样,但也不能直接否认iPhone 多镜头没有任何作用,毕竟在超广角、望远镜头拍摄中,还是利用光学镜头比起数位变焦会来的更好。

Halide 认为虽然iPhone SE2 单镜头和采用最新「机器学习」技术,但是深度讯息获取能力不比iPhone 11双镜头或iPhone 11 Pro 系列三镜头来的好。

主要原因是iPhone SE2 仅只是靠机器学习来判断一张2D平面照片的实际深度,特别是在拍摄非人像时,就容易无法识别主体与背景之间的距离,容易导致误判情况。

疯先生在实际拿iPhone 11 Pro 系列测试,发现三镜头也并非会同时间启动取得场景深浅,一次只会同时启动两颗镜头来判别与计算,这也是为何多镜头下能够拍出非人像以外的事物,会比起单镜头来的准确。